728x90

반응형

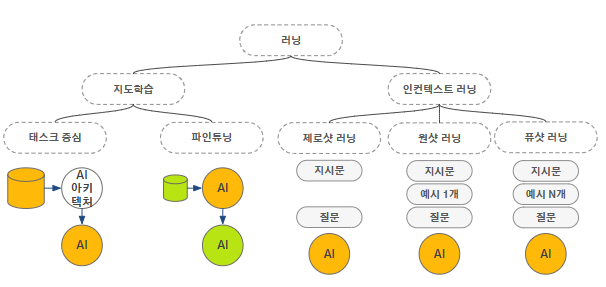

전이학습 (Transfer Learning)

; 한 작업에서 학습한 지식을 다른 관련작업에 이전하여 학습 성능을 향상시키는 기술.

새로운 모델을 생성할 때, 충분한 양의 데이터가 없거나 학습에 많은 비용이 들어가는 경우가 많다.

이러한 문제를 해결하기 위해 이미 학습된 모델이나 그 모델의 일부를 새로운 작업에 활용하는 방식을 전이학습 이라고 한다.

이전 모델에서 일부 또는 전체 파라미터를 조정하여 새로운 모델에 적합하도록 만든다. 적은 양의 데이터로도 높은 성능을 달성할 수 있다는 장점이 있다.

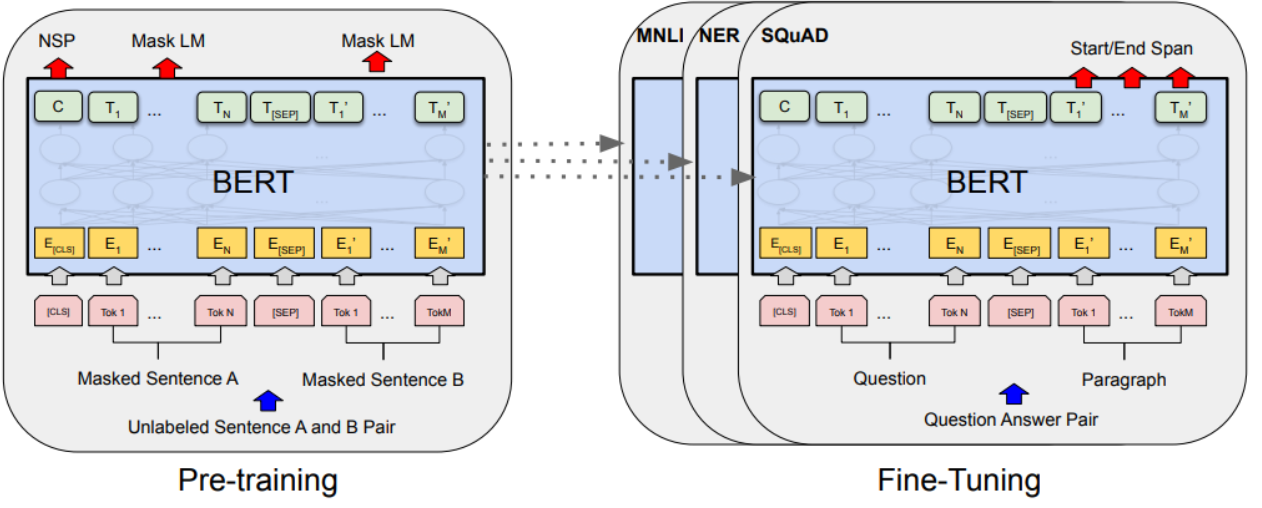

사전학습 (Pre-trained)

; 대규모 데이터셋으로 미리 학습된 모델.

사전학습된 모델들은 일반적이고 추상화된 특성들을 학습하도록 설계되었다.

위 전이학습에서 필요한 사전학습된 모델이 이에 해당한다.

파인튜닝(Fine Tuning)

; 사전학습된 모델의 일부 또는 전체 파라미터를 새로운 작업에 맞게 미세하게(fine) 조정(tuning).

위 전이학습에서 사전학습된 모델을 가지고 새로운 작업에 활용할 때, 필요에 맞게 파라미터를 조절하여 사용하게 된다.

이를 파인 튜닝이라고 한다.

Upstream / Downstream task

- Upstream task: 전이학습에서 사용되는 사전학습 모델이 사전학습하는 단계

ex) 단어예측, 문맥/문장/단어 간의 관계를 학습

- Downstream task: 사전학습된 모델을 새로운 작업에 사용할 때 미세조정을 통해 재사용하는 단계

ex) 문서 분류, 감정분석, 개체명인식 등

in- context 러닝

; 모델이 주어진 컨텍스트를 이해하고 이를 바탕으로 새로운 입력에 대응하는 것.

- 퓨샷

- 원샷

- 제로샷

728x90

반응형

'Natural Language Processing' 카테고리의 다른 글

| [ChatGPT] Prompt Engineering (0) | 2023.08.03 |

|---|---|

| [NLP] Transformer 트랜스포머 모델 (0) | 2023.08.01 |

| [NLP] Sequence to Sequence 모델 (0) | 2023.08.01 |

| [NLP] Word2Vector (0) | 2023.08.01 |

| [NLP] 정규표현식 (0) | 2023.07.25 |