728x90

반응형

각 레이어의 노드 수:

입출력의 노드의 수는 차원을 가리킨다.

활성화 함수

x값이 0이상이 되면 1에 급격하게 가까워진다.

RNN구성시 활성화함수를 사용한다.

ReLU함수를 가장 많이 사용 >> 성능이 잘나와서..ㅎㅎ

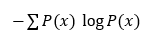

확률이 낮을수록 정보량은 높아진다.

KL 다이버전스

우도함수: 이유- 모델이 파라미터를 결정할때, 최대우도 추정함. 그래서 함수를 허용 세타가 정해져있을때, 최대값을 정하기 위해 함수 사용

이때 엔트로피 개념 사용 값이 너무 커서? 로그를 취함

-(마이너스) 도 엔트로피개념에서 나옴

엔트로피는 정보이론에서 파생됨

자주 발생하는 것은 확률 높음

드물게 발생하는 사건이 정보량이 높음

> 결과적으로 -log

(kl은 참고만)

두개의 확률(p와 q) >> 교차 엔트로피= 크로스 엔트로피

네거티브 로그우도의 초소값

두개의 값(확률)로 계산 ↓

로그값을 소프트 맥스 함수에 넣어 나온 값으로 최종예측값을 출력

가장 높은 확률을 가진 값을 최종 예측값으로 !

728x90

반응형

'Deep Learning' 카테고리의 다른 글

| [DL] AutoGrad (수정중) (0) | 2023.08.13 |

|---|---|

| [DL] rnn 과 lstm (수정중) (0) | 2023.08.10 |

| [DL] CNN_2 (0) | 2023.08.10 |

| [DL] CNN (0) | 2023.08.09 |

| [DL] 딥러닝 개요_1 (0) | 2023.08.07 |